どうも🎵最近ローカルのLLMにとても興味のある姫川ゆうです!

そんな最近、先日Xのタイムラインに流れてきた以下の情報がとても気になったので、早速実践してみたいと思います!

以前もローカルLLMに関しては試してみていたのですが、なかなかうまくいかないことが多くて、今回、CUIベースだったOllamaがGUIで実装されたということで、物は試しで導入をやってみたいと思います。

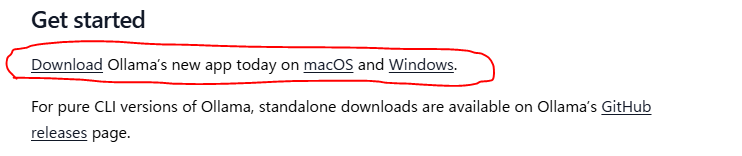

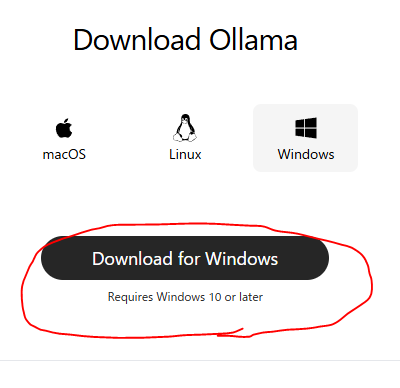

公式サイトからダウンロード

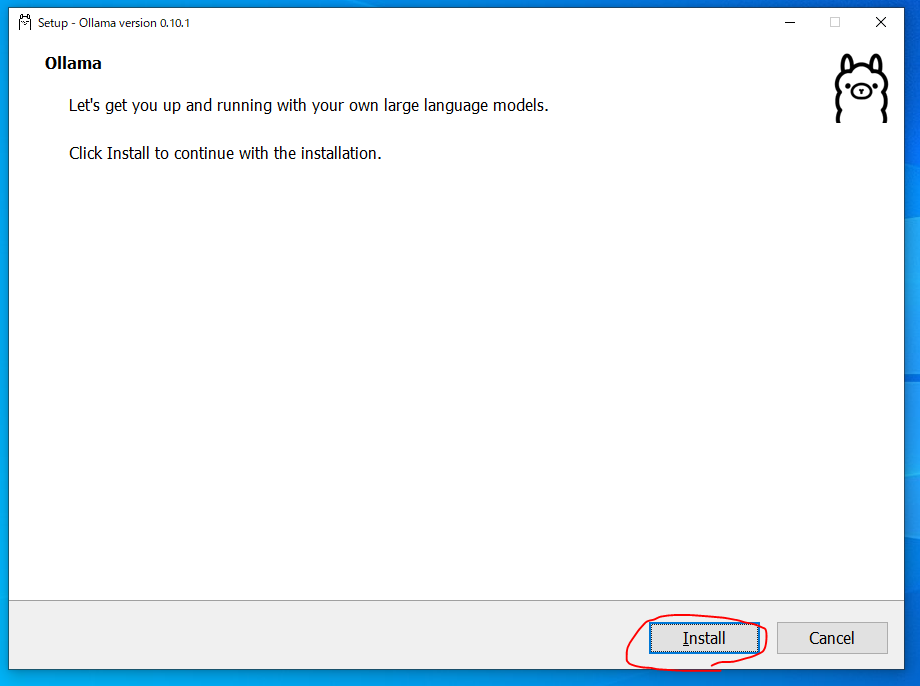

インストール

ダウンロードしてきたexeファイルをダブルクリックで超簡単にインストールできます。

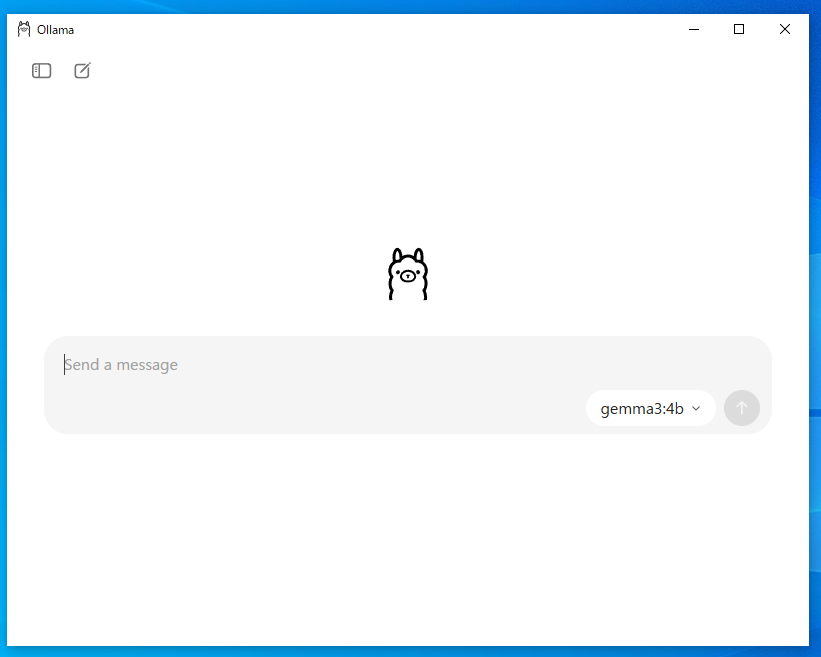

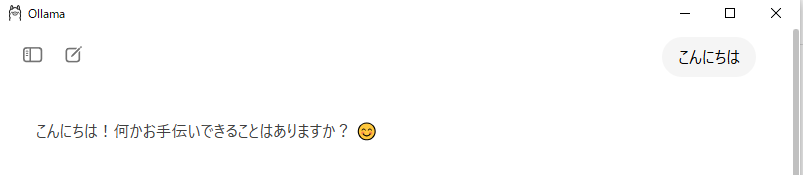

インストールは数分で終わり、以下のウインドウが立ち上がりました!かわいい!

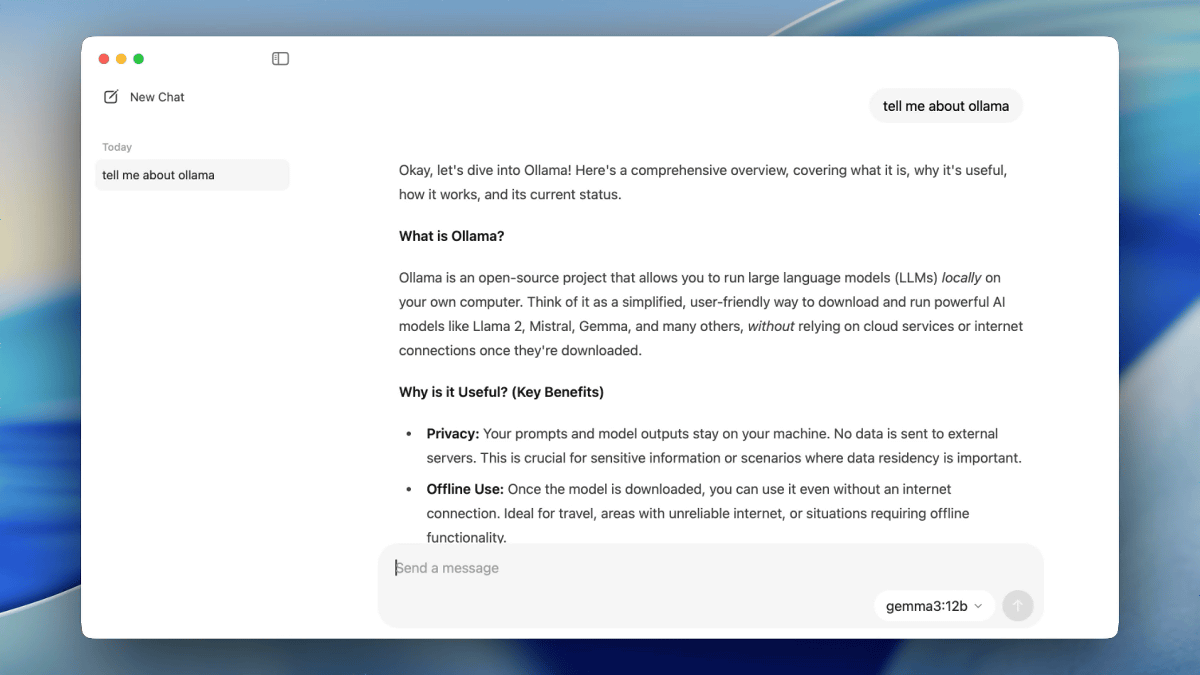

使ってみる

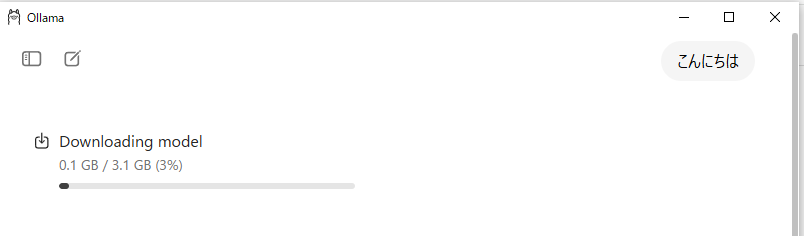

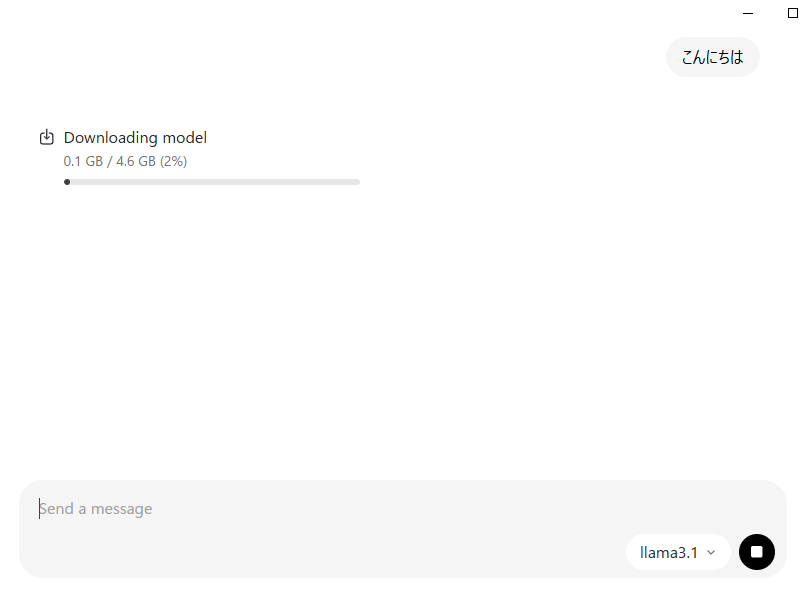

初めて、ためしに【こんにちは】と入れてみたら、その時点で何かのモデルのダウンロードが始まりました。

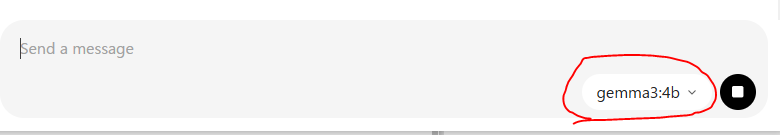

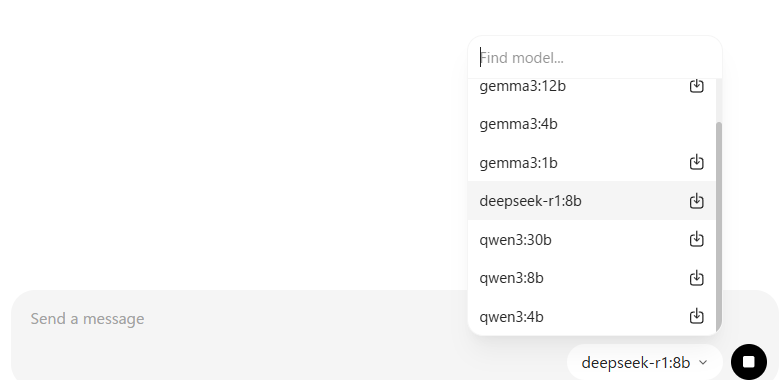

どうやらモデルはチャット入力欄の右下にある赤枠の部分で選択してやりとりするみたいなのですが、初回はダウンロードから、という感じですかね。

モデルのダウンロードが終わると、チャットに応答してくれました!

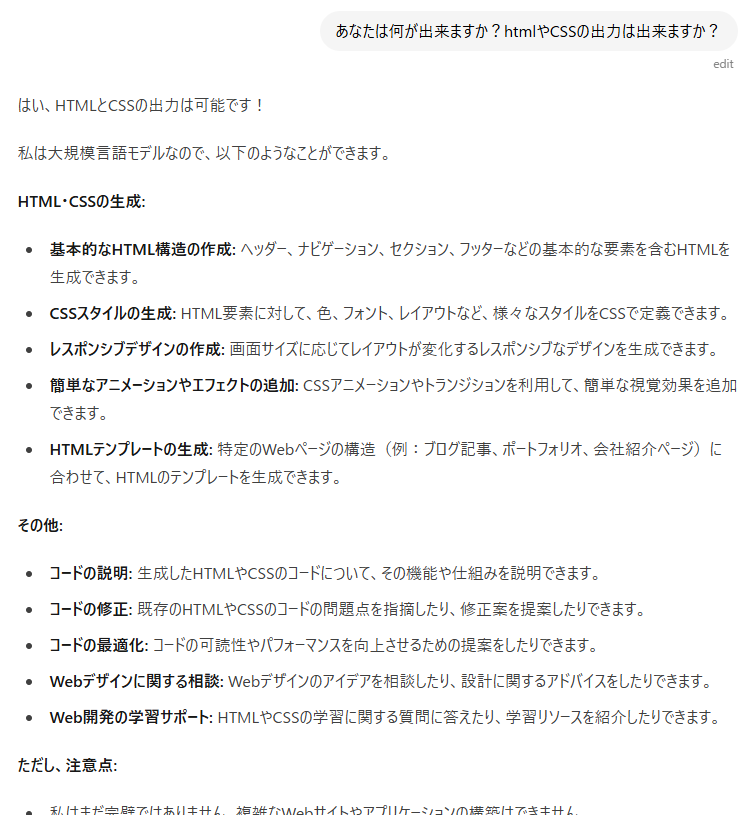

試しにhtmlやCSSが書けますか?と聞くと以下の回答がありました!

とりあえず実際にこの環境でhtml/cssを出力することはなさそうなので特にこれ以上お願いはしませんでしたが、ローカル環境の魅力は、いろんなモデルをインストールして試してみることが出来るところだと思うので、モデルの追加に関して調べてみたいと思います。

モデルの追加方法

チャット入力欄の右下には、いくつかデフォルトでモデルが選べるようになっているのですが、これ以外のモデルをどうやって追加するのか調べてみたいと思います。

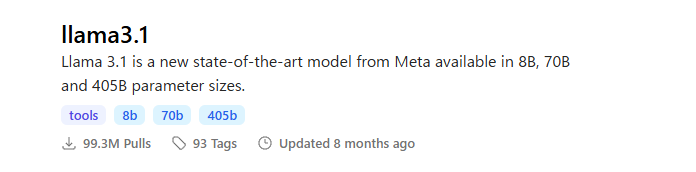

Ollamaの以下のサイトで追加するモデルを検索できるようです。

例えばこちらを追加したいとして

Ollamaのチャット欄右下のモデル選択の部分で↑を検索したら出てきたのでインストールしてみます。

該当モデルを選択してこんにちはと一言いえばダウンロードが始まるようです!

ダウンロードが完了すると、普通にチャット出来るようになりました。

まとめ

いかがでしたか?そもそも私もChatGPTに課金しており、特段ローカルでLLMをバリバリ動かす必要があるのか?という感じではありましたが、画像生成や動画生成はローカルで積極的に導入している中で、LLMの導入は中々手が付けられていなかったので、今回思い立ってやってみました。

ちょっとしたことをローカルで聞いてみる分には、GUIで操作しやすく、わりと動きもサクサクしているので、たまに使ってみようかな…!と思っています!

こんな感じで、ヘスティアワークスでは引き続きAIに関する実践ベースのやってみた記事を定期的に掲載していきます!